Überall ist zu lesen, dass Daten ein wichtiger strategischer Rohstoff sind. Und immer geht es darum wie Daten gewonnen werden, was damit möglich ist, aber kaum einer zeigt, wie aus den riesigen Datenmengen sinnvolle Erkenntnisse und Wissen gewonnen werden kann. Dabei gibt es einen Prozess, der in nur sieben Schritten Daten in Wissen verwandelt. Erfahren sie in den folgenden Schritten, wie aus Big Data Wissen entsteht.

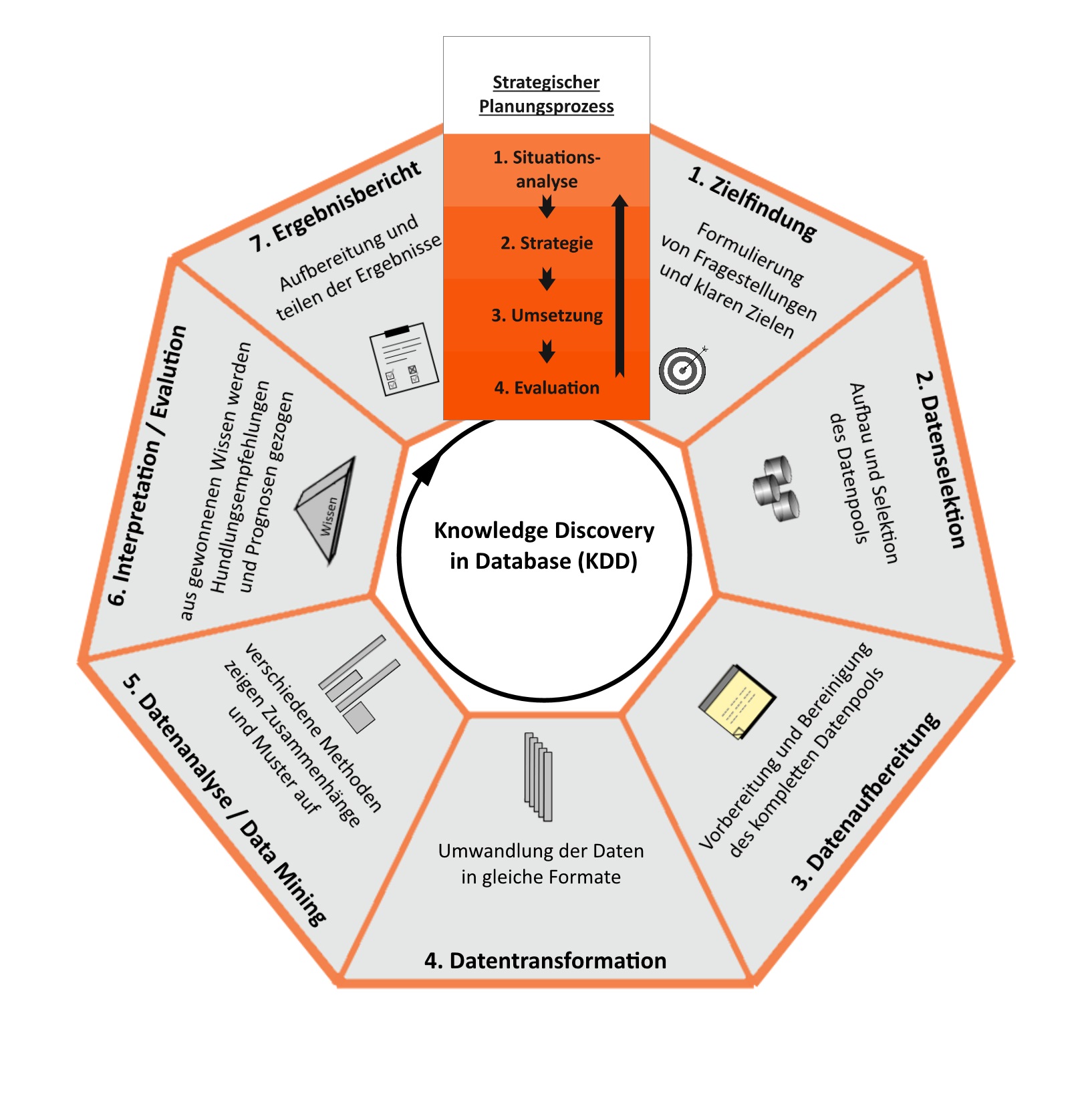

Das Schlüsselwort ist der Knowledge-Discovery-in-Databasses-Prozess (KDD), was so viel wie Wissensentdeckung in Datenbanken bedeutet. Der Grundprozess ist nicht neu, er wurde von den Datenwissenschaftlern Usama Fayyad, Gregory Piatetsky-Shapiro und Padhraic Smyth schon im Jahre 1996 entwickelt und das heute am meisten Verwendete Modell stammt aus dem Jahre 2014. Dieser Prozess der Wissensentdeckung in Kombination mit dem Vier-Phasen-Kreislauf der strategischen Planung bildet das was in heutigen Unternehmen zu stetigen Verbesserung führt.

Der strategische Planungsprozess besteht aus vier Phasen. Der Situationsanalyse, hier wird der IST-Zustand wahrgenommen. In der zweiten Phase wird der Weg zur Zielerreichung mit Hilfe der strategischen Analyse festgelegt. Darauf folgt die Umsetzung und zum Schluss die Evaluation, also die Bewertung ob Ziel ausreichend erreicht wurde. Wenn die Lösung nicht befriedigend ist, beginnt der Kreislauf von vorne bzw. es wird das nächste Ziel in Angriff genommen.

Die sieben Schritte zur Anwendung von Big-Data

1. Zieldefinition

Damit die gesammelten Daten den strategischen Planungsprozess unterstützen können, müssen eindeutige Ziele und Fragestellung für die Datenanalyse definiert werden.

2. Datenselektion

Sobald die Ziele definiert wurden, muss ein dafür passender Datenpool aufgebaut werden. Es wird geprüft welche Daten schon vorhanden sind und welche aus weiteren Quellen hinzugezogen werden können. Dieser Punkt ist essenziel für die Datenanalyse, wenn die betrachteten Daten nicht zur Fragestellung passen werden falsche Schlüsse gezogen und wenn die Datenformate der vorhandenen Daten unterschiedlich sind, können diese nicht miteinander verglichen werden. Daher ist es wichtig bei der Auswahl der Daten detailliert auf die 3 V’s, Volume, Velocity und Variety zu achten.

3. Datenbereinigung

Nun folgt der zeitintensivste Schritt die Bereinigung der Datensammlung. Hier wird der Datensatz für die Bearbeitung vorbereitet. Dazu zählen Aufgaben wie den Datensatz von Spam und irrelevanten Daten zu säubern, um relevante Daten erweitern oder Texte lesen, prüfen und wenn nötig korrigieren.

4. Datentransformation

Dieser Schritt beschreibt die Umwandlung der Rohdaten in andere Formate. Das Ziel dieses Schrittes ist Datenreduktion, indem viele Variablen in einen einzelnen Merkmal zusammengefasst werden. Dazu gehören beispielsweise Texte- und Bilddateien in gleiche Datenformate zu bringen oder die vorhandenen Daten zu gruppieren, hierfür bietet sich im Big-Data-Umfeld der k-Means-Algorithmus an. So wird es möglich große Datenbestände mit Hilfe von Repräsentanten einer Teilmenge leichter zu analysieren.

5. Datenanalyse (Data Mining)

In diesen Schritt findet die eigentliche Wissensgewinnung statt, hier werden verschiedenste Datenanalyse- und Data-Mining-Verfahren durchgeführt. Abgeleitet vom festgelegten Ziel wird innerhalb des Data Minings festgelegt: Welche Daten genau analysiert werden sollen? Welches Verfahren eignet sich dafür? Ausgehend davon wird das passende Verfahren ausgewählt.

Darauf folgt meist eine deskriptive Analyse, welche verschiedene Kennzahlen für die jeweiligen Eigenschaften auswertet. Zusammenhänge und Muster werden mit Hilfe der diagnostischen Analyse geprüft und die prädiktive Analyse, welche versucht Vorhersagen zu treffen, kann auch im Data Mining in Betracht gezogen werden. Allgemein gilt, je mehr Daten und Analysen vorliegen, desto zutreffender sind die Prognosen.

6. Interpretation/Evaluation

Hier wird noch einmal geprüft, ob die verwendeten Analysen mit passenden Daten durchgeführt wurden und die Ergebnisse logisch zum gesetzten Ziel passen. Das Ergebnis wird durch präskriptive Analyse Methoden interpretiert und es werden Handlungsempfehlungen abgeleitet, welche zum Ziel führen.

7. Ergebnisaufbereitung

Im letzten Schritt werden Kernergebnisse aufbereitet und vermittelt. Dazu können z.B. Graphen, Diagramm oder Dashboards herangezogen werden. Die gewonnenen Informationen sollten durch gute Datenvisualisierung und Informationsdesign präsentiert werden um diese effizient zu erläutern. Die Folge dieses Prozesses können zum Beispiel Veränderungen in der Lagerpolitik bringen, Automatisierung der Rechnungslegung, etc.